正则化(Regularization)和归一化(Normalization)是机器学习和深度学习中两个重要的数据预处理和模型优化技术,它们在目的、应用场景和方法上存在显著差异。以下将从定义、目的、应用场景、方法和区别等方面详细阐述。

一、定义

1. 归一化(Normalization)

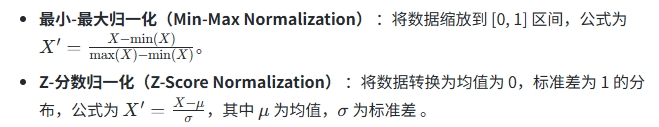

归一化是一种数据预处理技术,其目标是将数据映射到一个特定的范围或分布,以消除不同特征之间的量纲差异,使模型能够更公平地处理每个特征。常见的归一化方法包括:

2. 正则化(Regularization)

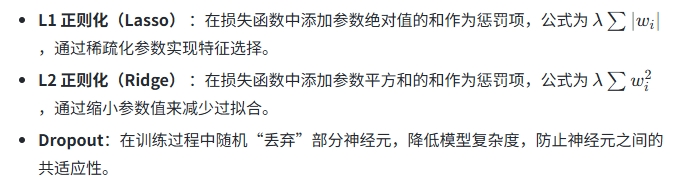

正则化是一种模型优化技术,其目的是通过在损失函数中添加惩罚项,限制模型的复杂度,从而防止过拟合(Overfitting),提高模型的泛化能力。常见的正则化方法包括:

二、目的

1. 归一化的目的

- 消除量纲差异:使不同特征在数值上具有可比性,避免因量纲不同导致模型偏向某些特征。

- 加快训练速度:通过标准化数据,使梯度下降过程更加平滑,提高模型收敛速度。

- 提高模型稳定性:减少异常值对模型的影响,使模型更鲁棒 。

2. 正则化的目的

- 防止过拟合:通过限制模型复杂度,减少模型对训练数据的过度拟合,提高模型的泛化能力。

- 提高模型泛化能力:通过引入先验约束,使模型在面对新数据时表现更稳定。

- 简化模型结构:L1 正则化可以实现特征选择,L2 正则化可以减少参数数量,使模型更简洁 。

三、应用场景

1. 归一化

- 数据预处理阶段:通常在数据清洗和特征工程阶段使用,用于标准化数据,使其适合后续模型训练。

- 神经网络:在图像识别、自然语言处理等任务中,归一化常用于输入数据的预处理,如图像像素值归一化。

- 支持向量机(SVM) :归一化可以提高 SVM 的分类性能,避免某些特征因量纲大而主导模型 。

2. 正则化

- 模型训练阶段:在模型训练过程中作为损失函数的一部分,用于线性回归、逻辑回归、神经网络等模型中。

- 深度学习:在神经网络中,正则化常用于防止过拟合,如 Dropout、L2 正则化等。

- 集成学习:通过正则化可以减少模型之间的复杂共适应性,提高集成模型的鲁棒性 。

四、方法

1. 归一化方法

- 最小-最大归一化:适用于数据分布稳定、无极端值的情况。

- Z-分数归一化:适用于数据存在异常值和噪音的情况,能够保留数据的分布特性。

- 平均归一化:将数据映射到 (-1, 1) 区间,适用于矩阵分解等场景。

- 非线性归一化:如 log 对数函数、反正切函数、sigmoid 变换等,用于处理非线性问题 。

- 批量归一化:对每一小批数据进行归一化,加速训练并提高模型稳定性,有一定类似正则化的效果 。

2. 正则化方法

- L1 正则化:通过稀疏化参数实现特征选择,适用于特征选择任务。

- L2 正则化:通过缩小参数值来减少过拟合,适用于大多数回归任务。

- Dropout:在训练过程中随机丢弃部分神经元,降低模型复杂度。

五、区别

| 特性 | 归一化 | 正则化 |

|---|---|---|

| 目的 | 消除特征间的量纲差异,使数据更便于处理 | 防止模型过拟合,提高泛化能力 |

| 作用对象 | 数据本身 | 模型参数 |

| 应用场景 | 数据预处理阶段 | 模型训练阶段 |

| 方法 | 数据缩放、标准化 | 损失函数中添加惩罚项 |

| 影响 | 影响数据的表示形式 | 影响模型的复杂度和泛化能力 |

| 是否改变模型本质 | 不改变问题的本质 | 通过约束模型复杂度,间接影响模型本质 |

六、总结

归一化和正则化在机器学习和深度学习中扮演着重要角色,但它们的侧重点和应用场景不同。归一化主要用于数据预处理,通过缩放数据消除量纲差异,使模型能够更公平地处理每个特征;而正则化则用于模型训练,通过限制模型复杂度,防止过拟合,提高模型的泛化能力。两者共同作用于提升模型性能和减少过拟合风险,但在具体实现和应用上存在显著差异

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!