KL散度约束(Kullback-Leibler Divergence Constraint)是一种用于衡量两个概率分布之间差异的非对称性度量方法,广泛应用于信息论、机器学习和强化学习等领域。其核心思想是通过KL散度来限制新旧策略或分布之间的距离,从而确保模型或算法在优化过程中不会偏离原始目标太远。

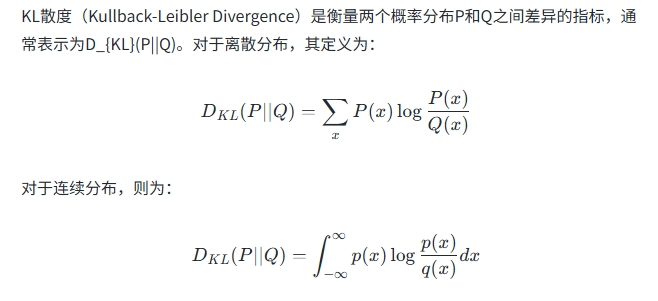

KL散度的定义

其中,P和Q分别是真实分布和近似分布。KL散度具有非对称性和非负性,即D_{KL}(P||Q) ≠ D_{KL}(Q||P),且D_{KL}(P||Q) ≥ 0。

KL散度的性质

非对称性:KL散度衡量的是从P到Q的“距离”,而不是对称的,因此它不能作为真正的距离度量。

非负性:KL散度总是大于等于0,当且仅当P=Q时取值为0。

与交叉熵的关系:KL散度可以表示为交叉熵与熵的差值,即H(P, Q) = H(P) + D_{KL}(P||Q),其中H(P)是P的信息熵。

KL散度约束的应用

KL散度约束在多个领域中被广泛应用,包括强化学习、信息论和统计学等。具体应用如下:

强化学习中的策略优化

在强化学习中,KL散度常被用作约束条件,以确保新策略不会与旧策略脱节。例如,在PPO(Proximal Policy Optimization)算法中,通过限制新旧策略之间的KL散度来防止过度优化导致性能下降。此外,TRPO(Trust Region Policy Optimization)算法也利用KL散度约束来优化策略,但其计算复杂度较高。

模型训练中的稀疏性约束

在神经网络训练中,KL散度可以用于稀疏性约束,例如通过最小化隐藏层激活值的KL散度来控制神经元的激活程度。

信息论中的分布匹配

KL散度常用于评估实际数据分布与理论分布之间的差异,例如在数据处理不等式中,KL散度被用来量化信息损失。

KL散度约束的优势与挑战

优势:KL散度约束能够有效控制新旧策略或分布之间的差异,从而保证模型的稳定性和鲁棒性。

挑战:由于KL散度的非对称性和计算复杂性,在实际应用中需要引入惩罚项或近似方法来简化优化问题。

总结

KL散度约束是一种重要的工具,用于衡量和控制两个概率分布之间的差异。它在强化学习、信息论和统计学等领域具有广泛的应用。通过合理设置KL散度约束,可以实现模型的稳定优化和性能提升。