集成学习方法是一种通过结合多个学习器来提高模型性能和泛化能力的机器学习技术。它通过训练多个学习器(通常称为“弱学习器”)并将其结合起来,以解决单一模型难以处理的问题。这种方法在机器学习领域中被广泛应用于各种复杂问题的解决中,如图像识别、自然语言处理、推荐系统等。

核心思想与原理

集成学习的核心思想是“弱者联合成强者”,即通过组合多个简单模型(弱学习器)来构建一个更强大、更稳健的模型。这些弱学习器可以是同质的(如决策树、神经网络等)或异质的(不同类型的模型)。通过结合多个模型的预测结果,集成学习能够有效减少偏差、方差和噪声的影响,从而提高模型的准确性和稳定性。

常见方法与分类

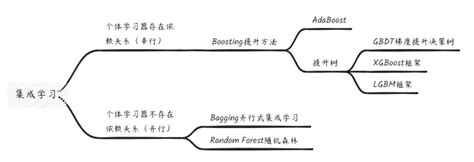

集成学习方法可以分为多种类型,主要包括:

- Bagging(自助采样法) :通过从训练集中进行有放回抽样,生成多个不同的训练子集,然后在每个子集上构建一个学习器,最后通过投票或平均法将这些学习器的预测结果进行集成。代表算法包括随机森林(Random Forest)。

- Boosting(提升法) :通过调整样本权重,逐步训练基学习器,最终加权组合。AdaBoost是Boosting的代表,其步骤包括初始化权重、循环训练基分类器、计算误差率、更新权重,最终加权平均得到结果。

- Stacking(堆叠法) :通过训练元模型(元学习器)来组合多个弱学习器的预测结果,进一步提升模型性能。

优势与应用

集成学习方法在许多实际应用中表现出色,尤其在处理复杂问题时,它常常能够比单一模型取得更好的结果。例如,在图像识别、自然语言处理、推荐系统等领域,集成学习已被广泛采用。此外,集成学习能够有效降低过拟合风险、提高模型的鲁棒性,并在多个学习器之间平衡偏差和方差。

与其他方法的对比

与传统机器学习方法相比,集成学习方法通过训练多个学习器并结合它们来解决一个问题,而传统方法通常训练一个学习器。集成学习方法在实践中获得了巨大成功,并成为机器学习领域的“常青树”,受到学术界和产业界的广泛关注。

总结

集成学习方法是一种通过结合多个学习器来提高模型性能和泛化能力的机器学习技术。它通过训练多个弱学习器并将其结合起来,以解决复杂问题。这种方法在多个领域中表现出色,具有广泛的应用前景和良好的性能表现

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!