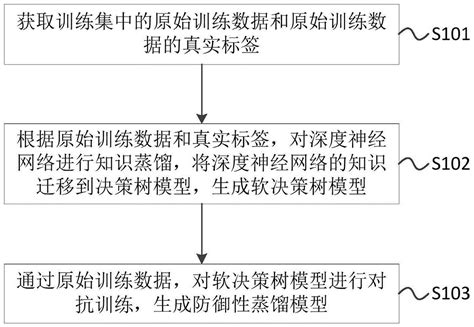

防御性蒸馏(Defensive Distillation)是一种用于提高深度学习模型对对抗性攻击(Adversarial Attacks)鲁棒性的技术。它通过知识蒸馏(Knowledge Distillation)的思想进行扩展,旨在提升模型的泛化能力和对抗攻击的防御能力。

核心原理与目标

防御性蒸馏的核心思想是通过训练一个学生模型(Student Model)来模仿教师模型(Teacher Model)的输出,从而提高模型的鲁棒性。具体而言,教师模型通常是一个较大的、计算量较大的模型,而学生模型则是一个更小、更高效的模型。在防御性蒸馏中,学生模型通过学习教师模型的软标签(Soft Labels)来提升其对输入扰动的敏感性,从而增强模型的泛化能力。

工作机制

- 知识蒸馏:防御性蒸馏本质上是一种知识蒸馏的变体。在传统的知识蒸馏中,学生模型通过模仿教师模型的输出来学习知识。而在防御性蒸馏中,这一过程被进一步优化,以增强模型的鲁棒性。

- 软标签训练:在防御性蒸馏中,学生模型的训练目标是模仿教师模型的输出概率分布(Soft Labels),而不是硬标签(Hard Labels)。这种软标签包含了更多的类别信息,有助于模型学习更平滑的决策边界,从而提高模型对对抗性攻击的防御能力。

- 平滑性增强:通过训练学生模型模仿教师模型的输出,防御性蒸馏可以降低模型对输入扰动的敏感性,从而提高模型的鲁棒性。实验表明,防御性蒸馏可以显著降低对抗样本的成功率,例如将对抗样本的成功率从95%降低到0.5%以下。

优势与局限性

优势:

- 提高鲁棒性:防御性蒸馏通过平滑模型的输出,提高了模型对对抗性攻击的防御能力。

- 计算效率:学生模型通常比教师模型更小、更高效,适合部署在资源受限的环境中。

- 可解释性:防御性蒸馏的原理较为清晰,便于理解和分析。

局限性:

- 防御效果有限:尽管防御性蒸馏在一定程度上提高了模型的鲁棒性,但其防御效果可能因攻击方法和应用场景而异。例如,某些攻击方法(如C&W攻击)可能绕过防御性蒸馏的防御。

- 性能权衡:防御性蒸馏可能会影响模型的分类准确率,尤其是在高蒸馏温度下,模型的鲁棒性可能与实际分布产生偏差。

应用场景

防御性蒸馏广泛应用于需要高安全性的领域,如自动驾驶、生物识别、内容过滤等,以提高模型的鲁棒性和安全性。

总结

防御性蒸馏是一种通过知识蒸馏和软标签训练来提高深度学习模型对对抗性攻击鲁棒性的技术。它通过平滑模型的输出,增强模型的泛化能力和对抗攻击的防御能力。尽管其在某些场景下表现出色,但其防御效果可能受攻击方法和应用场景的影响。未来的研究可以进一步探索结合其他防御机制(如对抗训练、输入变换等)以构建更安全的深度学习系统

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!