在人工智能领域,解码器(Decoder)是一种关键的模型组件,其主要作用是将编码器(Encoder)输出的压缩表示或特征向量转换为可理解的输出,如文本、图像或音频等。解码器通常与编码器一起工作,形成一种编码-解码的结构,这在处理序列数据时尤其常见。

解码器的基本结构和功能

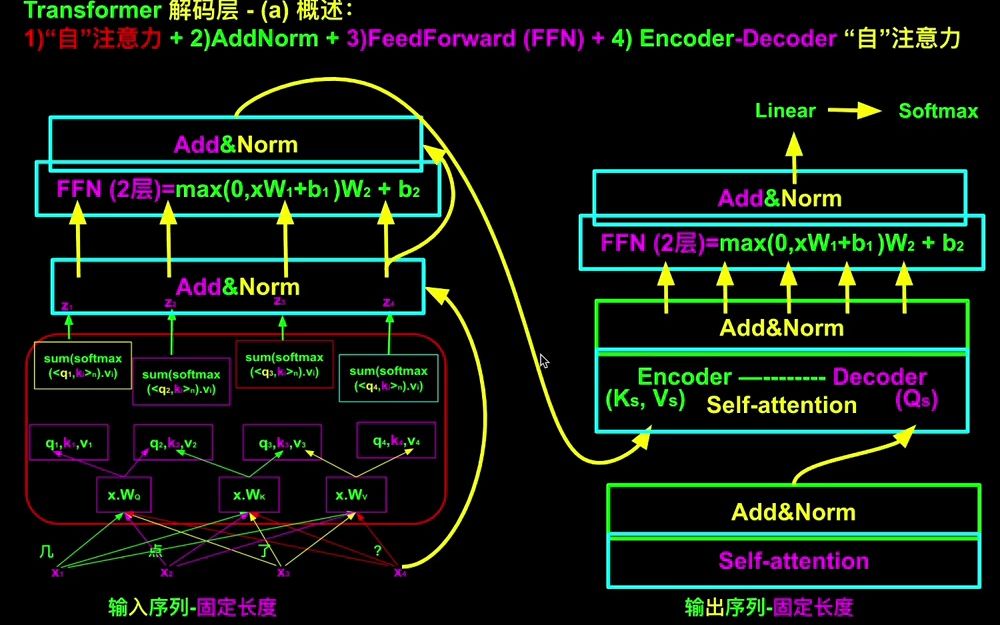

解码器通常由多个相同结构的层堆叠而成,每一层包含一个多头自注意力子层、一个编码器-解码器注意力子层和一个前馈神经网络子层。在论文中,Transformer由1个输入层、6个解码层和1个输出层构成,同样实践中层数可自行设置。解码器的作用是根据编码器的输出和先前生成的部分目标序列来逐步生成目标序列。

解码器的应用

1. 文本解码器

在自然语言处理中,解码器可以是基于RNN、LSTM或Transformer的结构,它们将编码器输出的向量转换成文本序列,应用于机器翻译、文本生成和聊天机器人等任务。例如,在Transformer模型中,解码器通过自注意力机制和前馈神经网络,逐步生成输出序列,确保生成的文本在当前时间步之前的部分不会被访问。

2. 图像解码器

在计算机视觉中,解码器通常是一个CNN或自编码器的一部分,它们将编码后的特征向量转换成像素值,用于图像重建、图像到图像的转换和风格迁移等。例如,在自编码器中,编码器将输入图像压缩为低维特征向量,而解码器则尝试将这些特征重构回原始图像。

解码器的结构

1. 自注意力机制

解码器中的自注意力机制(Self Attention)允许模型在生成每个输出时关注输入序列的不同部分,从而提高模型的性能。与编码器不同,解码器接收编码器的输出作为输入,通过自注意力机制计算输入词的键值对(K和V),并与解码层的查询向量(Q)进行匹配,从而生成输出。

2. 前馈神经网络

前馈神经网络(Feed Forward Neural Network)是解码器中的另一个重要组成部分,负责处理自注意力机制的输出,并生成最终的输出向量。前馈神经网络通常包括线性层和激活函数,如Sigmoid,用于将输出值压缩到0到1之间,适合图像像素值。

3. 编码器-解码器注意力机制

编码器-解码器注意力机制(Encoder-Decoder Attention)允许解码器在生成每个输出时关注编码器的输出,从而更好地利用编码器的信息。这一机制在Transformer模型中尤为重要,因为它确保了解码器能够利用编码器的信息来生成高质量的输出。

解码器的训练过程

解码器的训练过程通常包括前向传播和反向传播。在前向传播中,输入数据通过编码器被转换为特征向量,然后通过解码器生成输出。在反向传播中,解码器的输出与目标输出进行比较,计算损失,并通过梯度下降更新解码器的参数。例如,在自编码器中,编码器将输入图像压缩为低维特征向量,而解码器则尝试将这些特征重构回原始图像。

解码器的应用实例

1. 机器翻译

在机器翻译任务中,编码器将源语言的句子转换为特征向量,而解码器则根据这些特征向量生成目标语言的句子。例如,Transformer模型在机器翻译任务中取得了显著的成果,其BLEU得分远超传统方法。

2. 图像生成

在图像生成任务中,编码器将输入图像压缩为低维特征向量,而解码器则尝试将这些特征重构回原始图像。例如,自编码器在图像生成任务中表现出色,能够生成高质量的图像。

3. 语音识别

在语音识别任务中,编码器将声音信号转换为向量序列,而解码器则根据这些向量序列生成输出文本。例如,Transformer模型在语音识别任务中表现出色,能够生成高质量的文本。

总结

解码器是人工智能领域中一个重要的模型组件,其主要作用是将编码器输出的压缩表示或特征向量转换为可理解的输出。解码器通常与编码器一起工作,形成一种编码-解码的结构,这在处理序列数据时尤其常见。解码器的结构包括自注意力机制、前馈神经网络和编码器-解码器注意力机制,这些机制共同作用,确保了解码器能够生成高质量的输出。解码器的应用广泛,包括机器翻译、图像生成和语音识别等任务