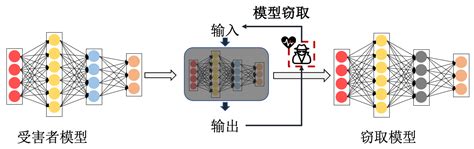

模型窃取(Model Theft)是一种针对AI模型的攻击方式,其目的是通过非法手段获取目标模型的参数、功能或训练数据,以复制或利用目标模型的知识产权和商业价值。这种攻击方式对AI系统的安全性和隐私保护构成了严重威胁,同时也可能引发法律、经济和声誉上的损害。以下从多个维度详细介绍模型窃取的定义、分类、攻击方法及其影响。

1. 定义与背景

模型窃取是指未经授权访问或复制机器学习模型的行为,包括黑盒和白盒两种攻击方式。黑盒攻击中,攻击者仅通过模型的输入和输出进行查询,而无法直接访问模型的内部结构或参数;而白盒攻击中,攻击者可以访问模型的架构和参数,甚至直接获取模型文件。

模型窃取通常发生在“机器学习即服务”(MLaaS)场景中,即攻击者通过API接口对模型进行查询,从而推断出模型的内部机制和功能。这种攻击不仅限于黑盒模型,也适用于公开的API或私有部署模型。

2. 分类与攻击方法

根据攻击目标和手段的不同,模型窃取可以分为以下几种类型:

2.1 黑盒攻击

黑盒攻击是最常见的攻击形式,攻击者通过向目标模型发送查询请求并分析其输出,逐步推断出模型的内部结构和功能。例如:

- 查询-响应模型:通过多次输入数据并观察模型输出,构建一个与目标模型功能相似的替代模型。

- 对抗样本生成:利用微小的扰动输入数据,观察模型输出的异常变化,从而推测模型内部逻辑。

- 缓存侧信道攻击:通过分析模型对不同输入的响应时间,推测模型内部结构。

2.2 白盒攻击

白盒攻击中,攻击者可以直接访问模型的参数和架构,因此攻击难度较低。例如:

2.3 特定技术手段

- 模型水印:通过在模型中嵌入特定的水印信号,攻击者可以追踪模型的来源。

- 代理模型攻击:训练一个与目标模型功能相似的模型,通过输入数据和输出结果进行参数优化,最终实现模型复制。

3. 攻击的影响与风险

模型窃取可能导致以下严重后果:

- 知识产权损失:攻击者可能复制模型并用于商业用途,导致原作者的经济利益受损。

- 数据泄露:模型可能隐含训练数据的敏感信息,攻击者可能通过模型输出推断出训练数据的隐私内容。

- 竞争优势丧失:竞争对手可能通过窃取模型功能,开发出性能更优的替代产品,削弱目标企业的市场地位。

- 法律与声誉风险:模型窃取可能涉及侵犯知识产权和隐私权,导致法律诉讼和品牌声誉受损。

4. 防御策略

为了应对模型窃取攻击,研究者和开发者提出了一系列防御措施:

- 访问控制:限制对模型的访问权限,仅允许授权用户查询。

- 数据混淆与水印技术:通过加密存储和动态水印技术,保护模型的知识产权和隐私。

- 模型压缩与混淆:通过压缩模型参数或混淆模型结构,降低攻击者复制模型的可行性。

- 对抗样本检测:利用对抗性训练和异常检测技术,提高模型对攻击的鲁棒性。

5. 总结

模型窃取是AI领域中一个复杂且隐蔽的威胁,其攻击手段多样,影响深远。从黑盒到白盒攻击,再到模型水印和代理模型攻击,这些方法都旨在复制或窃取模型的知识产权和功能。为了保护模型的安全性和隐私,开发者需要采取多层次的防御策略,包括技术防护、法律保护和持续监控等。未来,随着AI技术的不断发展,模型窃取的攻击手段和防御策略也将不断演变,需要持续关注和研究。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!