梯度提升决策树(Gradient Boosting Decision Tree, GBDT)是一种强大的机器学习算法,广泛应用于分类和回归问题中。它是一种集成学习方法,通过迭代训练多个决策树来提升模型的预测能力。GBDT的核心思想是通过优化损失函数的梯度下降来逐步提升模型的预测准确性。它通过构建多个决策树模型,并将它们组合在一起来实现更好的预测性能。

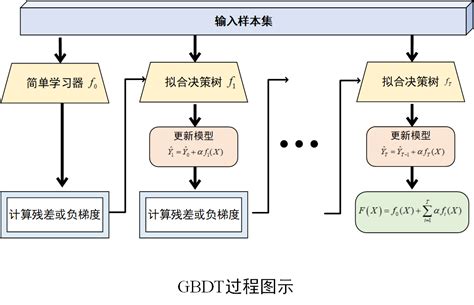

GBDT的工作原理是通过迭代地构建一系列弱预测模型(通常是决策树),每个新的模型都试图纠正前一个模型的错误。在每轮迭代中,根据当前模型的残差(真实值与预测值之差)来训练一个新的决策树,然后将这个新树添加到模型中,以不断减少预测误差。GBDT的核心思想是利用梯度信息指导决策树生成,不同任务对应不同损失函数。

GBDT是一种基于梯度提升的决策树算法,它通过加权处理误分类样本提升模型性能。GBDT能处理数值、类别和有序特征,自动学习特征重要性,具有较强的特征选择能力。GBDT在分类和回归任务中表现优异,但需注意超参数调优和计算资源。

GBDT的训练过程包括初始化模型、计算负梯度、训练弱分类器并迭代优化。GBDT的算法流程包括初始化、迭代计算残差、拟合决策树、更新预测等步骤。GBDT的关键参数如迭代次数、学习率、树深度等影响模型性能,需合理调优。

GBDT在许多领域广泛应用,如金融、医疗和推荐系统等。GBDT在AI产品中广泛用于推荐系统、搜索排序、广告点击率预测和金融信用评分等场景。GBDT的可解释性强,预测速度快,但计算成本高,需合理调参。

GBDT是一种强大的集成学习方法,通过迭代训练多个决策树来提升模型性能,广泛应用于分类和回归问题中

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!