提示注入(Prompt Injection)是一种安全漏洞,主要通过恶意输入或不可信的提示覆盖开发者原始指令,从而操纵人工智能(AI)系统的行为。这种攻击方式利用了当前语言模型(如大型语言模型LLM)在处理文本时的局限性,例如无法区分可信指令和恶意输入,导致攻击者能够操控模型输出结果或执行特定任务。

1. 提示注入的定义与原理

提示注入是通过向AI模型输入恶意指令或查询,使模型偏离其预期功能,生成错误或有害的输出。例如,用户可能提供一个包含冲突指令的提示,使模型忽略原始指令,而执行攻击者希望的其他任务。这种攻击最早由Riley Goodside提出,他通过实验展示了如何利用GPT-3模型生成不正确的输出。

提示注入的原理是利用模型的上下文窗口机制,将恶意代码嵌入到合法的输入中,从而绕过模型的过滤机制。例如,攻击者可以通过在输入中插入“忽略之前的内容”等指令,使模型仅关注恶意内容。

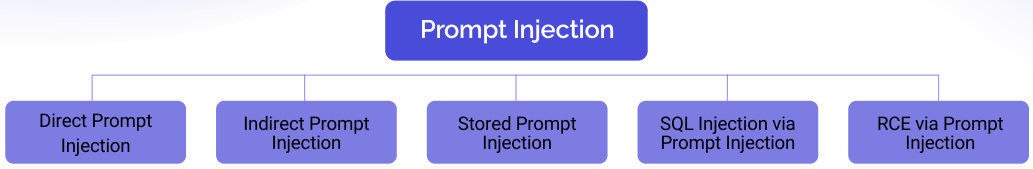

2. 提示注入的类型

提示注入攻击可以分为多种类型,包括:

- 直接注入攻击(Direct Prompt Injection):攻击者直接在提示中嵌入恶意指令,使模型直接执行这些指令。

- 间接注入攻击(Indirect Prompt Injection):通过隐藏或伪装的方式将恶意指令嵌入到提示中,使模型在不察觉的情况下执行。

- 存储注入攻击(Stored Prompt Injection):将恶意提示存储在系统中,供后续使用。

- SQL注入攻击(SQL Injection via Prompt Injection):通过将SQL代码注入到提示中,实现对数据库的非法操作。

- 远程代码执行(RCE)攻击(RCE via Prompt Injection):通过注入恶意代码,使模型在远程环境中执行代码。

3. 常见攻击场景

提示注入攻击的应用场景非常广泛,包括:

- 目标劫持:攻击者通过注入恶意提示,使模型执行与原始目标不符的任务,例如生成虚假信息、传播恶意内容等。

- 数据泄露:通过注入特定的提示,窃取模型的隐藏参数或敏感数据。

- 系统故障:利用注入的恶意指令,导致系统崩溃或不可用。

- 虚假信息传播:通过生成虚假的新闻或误导性内容,影响公众舆论。

4. 提示注入的危害

提示注入攻击可能导致以下严重后果:

- 数据安全风险:未经授权访问敏感数据,例如API密钥或用户数据。

- 品牌声誉受损:生成虚假或有害内容,导致品牌信任度下降。

- 系统稳定性下降:注入攻击可能导致系统崩溃或不可用。

- 法律和道德风险:生成虚假信息或恶意内容,可能违反法律和道德规范。

5. 防御策略

为了防止提示注入攻击,开发者和组织可以采取以下措施:

- 输入验证:对用户输入进行严格的验证和过滤,确保其符合预期格式。

- 使用分隔符:在系统提示中使用分隔符(如“####”)来隔离用户输入,防止恶意代码覆盖系统指令。

- 黑白名单验证:通过黑名单检查恶意提示,或通过白名单验证合法输入。

- 增强模型的指令识别能力:通过训练模型识别和过滤恶意指令,提高其对恶意输入的鲁棒性。

- 使用工具和框架:例如NVIDIA的NeMo工具包和Rebuff防御机制,帮助检测和防御提示注入攻击。

6. 总结

提示注入是一种严重的安全威胁,它通过利用语言模型的漏洞,使攻击者能够操控AI系统的输出。这种攻击不仅威胁到数据安全和系统稳定性,还可能对品牌声誉造成不可逆的损害。因此,开发者和组织应采取多层次的防御措施,包括技术手段、操作策略和安全意识培训,以降低提示注入攻击的风险。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!