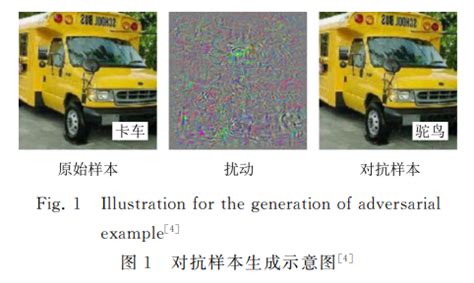

对抗样本(Adversarial Examples)是机器学习领域中的一个重要概念,尤其在深度学习模型中具有显著影响。它指的是通过在原始输入数据上添加微小、人眼难以察觉的扰动,从而导致模型以高置信度给出错误分类的样本。这种现象揭示了深度学习模型在理解数据本质方面的局限性,并对安全攸关的应用(如自动驾驶、医疗诊断)构成了严重威胁。

对抗样本的定义与特点

对抗样本的核心特征在于其“难以察觉”和“高置信度错误输出”。具体来说:

- 难以察觉:对抗样本通常在人类观察者看来与原始样本无异,但能够导致机器学习模型出错。

- 高置信度错误输出:模型在面对对抗样本时,往往以高置信度给出错误的分类结果,这表明模型对输入数据的敏感性较高,且对微小扰动的响应能力较强。

- 生成方式:对抗样本通常通过在原始输入上添加微小扰动(如像素值的微调)生成,这些扰动在人类感知中几乎不可察觉。

对抗样本的生成与原因

对抗样本的生成最早由 Christian Szegedy 等人在 2014 年提出,他们通过在数据集中添加细微的干扰,使模型以高置信度给出错误输出。这一现象的产生原因与深度学习模型的“线性性质”有关,即模型在高维空间中对微小扰动的敏感性较高。此外,对抗样本的生成方法包括多种攻击策略,如快速梯度符号方法(FGSM)、投影梯度下降(PGD)等。

对抗样本的影响与防御

对抗样本的存在揭示了深度学习模型的脆弱性,尤其是在图像识别、目标检测等任务中,模型可能因对抗攻击而产生错误输出。为了应对这一问题,研究者提出了多种防御策略,包括对抗训练、模型蒸馏、隐藏梯度等方法。然而,对抗样本的生成和防御仍面临诸多挑战,如生成算法的非线性、非凸性以及防御方法的复杂性。

对抗样本的应用与研究

对抗样本不仅在学术界受到广泛关注,也在实际应用中具有重要意义。例如,在自动驾驶、人脸识别等高安全需求领域,对抗样本的存在可能限制深度学习模型的应用。此外,对抗样本的研究推动了机器学习模型的鲁棒性提升和安全性增强。

总结

对抗样本是深度学习领域中的一个重要现象,其核心在于通过微小扰动导致模型错误输出。对抗样本的生成和防御是当前机器学习安全研究的重要方向,其研究不仅有助于理解模型的脆弱性,也为构建更安全、更可靠的机器学习系统提供了理论支持和实践基础

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!