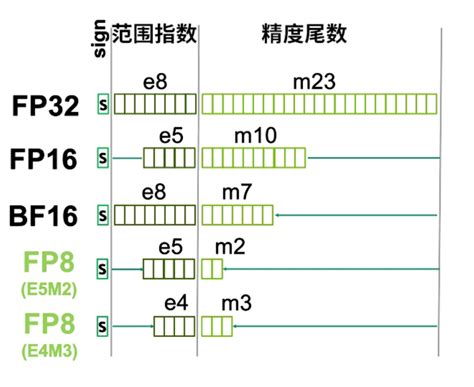

BF16(BFloat16)是一种16位浮点数格式,专为深度学习和人工智能计算设计,由Google Brain团队提出并广泛应用于TPU(Tensor Processing Unit)等硬件中。BF16的结构包括1位符号位、8位指数位和7位尾数位,总位数为16位。与传统的FP32(32位浮点数)相比,BF16的精度较低(7位尾数位),但其指数位与FP32相同,因此具有与FP32相似的动态范围,能够表示较大的数值范围(约1e-38到3e38)。

BF16的主要优势在于其高计算效率和低内存占用。由于其16位的位宽,BF16在硬件上处理速度更快,内存占用仅为FP32的一半,适合大规模深度学习模型的训练和推理。此外,BF16在深度学习中被广泛采用,因为它能够在保持一定精度的同时,显著降低计算和能耗。

然而,BF16的精度较低,可能影响某些对精度要求极高的任务。尽管如此,BF16在许多深度学习任务中表现出色,尤其是在大型模型训练中,能够减少梯度或激活值溢出的风险,提高训练稳定性。BF16已被广泛支持于多种硬件平台,包括Google TPU、NVIDIA A100、Intel Xeon等。

BF16是一种在深度学习和人工智能领域中广泛应用的高效浮点数格式,通过平衡精度与效率,为大规模计算提供了重要的技术支持

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!