随机梯度下降法(SGD)概述

随机梯度下降法(Stochastic Gradient Descent,SGD)是一种广泛应用于机器学习和深度学习中的优化算法,主要用于最小化损失函数。SGD的基本思想是在每次迭代中,随机选取一个样本或一个小批量样本,计算其对应的梯度,并据此更新模型参数。这种方法相比传统的批量梯度下降法(Batch Gradient Descent,BGD),具有更快的训练速度和更好的泛化能力。

SGD的工作原理

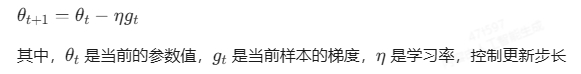

SGD的核心在于每次迭代仅使用一个样本或一个小批量样本进行参数更新,而不是像BGD那样使用整个训练集。这种做法大大减少了每次迭代所需的计算资源,使得SGD能够在大数据集上高效运行。SGD的更新公式为:

SGD的优点和缺点

优点

- 速度快:由于每次迭代只需要处理一个或几个样本,SGD的训练速度远快于BGD。

- 适用于大数据集:SGD不需要加载整个数据集到内存中,适合处理大规模数据。

- 避免局部最优:SGD的随机性有助于跳过局部最优解,增加找到全局最优解的机会。

缺点

- 准确性下降:由于每次迭代使用的样本数量较少,SGD的梯度估计可能存在较大偏差,导致模型精度下降。

- 可能收敛到局部最优:虽然SGD具有跳出局部最优的能力,但在某些情况下仍可能收敛到局部最优解。

- 不易于并行实现:SGD的随机性使得其难以充分利用现代硬件的并行计算能力。

SGD的应用

SGD因其高效性和适用性,被广泛应用于各种机器学习和深度学习任务中,包括支持向量机、逻辑回归、文本分类和自然语言处理等。

改进版SGD

为了克服SGD的一些局限性,研究者提出了多种改进版本,如带有动量的SGD、AdaGrad、Adam等。这些方法通过引入动量、自适应学习率等机制,进一步提高了SGD的性能和稳定性。

结论

随机梯度下降法(SGD)是一种高效的优化算法,特别适合处理大规模数据集和复杂模型。尽管它存在一些局限性,但通过适当的调整和改进,SGD仍然是许多机器学习和深度学习任务中的首选优化方法。

声明:文章均为AI生成,请谨慎辨别信息的真伪和可靠性!